Data Pipelines – Quy Trình Và Cách Thực Hiện

DATA ENGINEERING

Tan Dung Dang

11/11/20247 min read

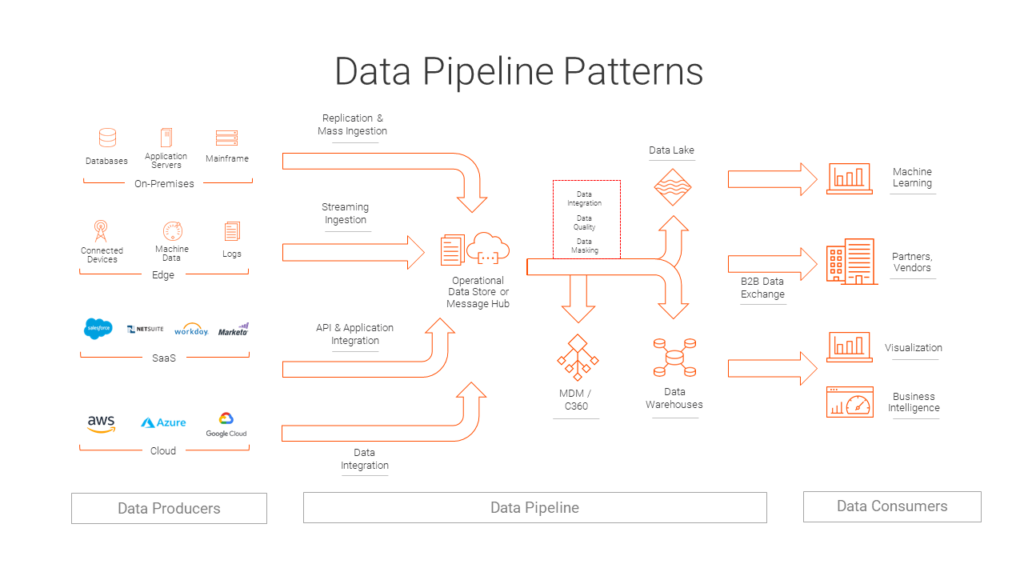

Trong thời đại dữ liệu lớn, Data Pipeline (Luồng dữ liệu) là một khái niệm quan trọng mà mọi Data Engineer cần nắm vững. Data Pipeline giúp tự động hóa quy trình thu thập, chuyển đổi và lưu trữ dữ liệu, giúp dữ liệu có sẵn để phân tích và đưa ra quyết định nhanh chóng. Bài viết này sẽ giải thích cách thức hoạt động của Data Pipeline, các bước xây dựng, và các công cụ phổ biến để giúp bạn tối ưu hóa quy trình dữ liệu của mình.

1. Data Pipeline Là Gì?

Data Pipeline là một hệ thống được thiết kế để di chuyển dữ liệu từ các nguồn đầu vào đến các hệ thống lưu trữ và phân tích. Quá trình này bao gồm việc thu thập dữ liệu từ các nguồn khác nhau, chuyển đổi dữ liệu để chuẩn hóa hoặc làm sạch và cuối cùng là tải dữ liệu vào một kho dữ liệu (Data Warehouse) hoặc một hệ thống phân tích.

Data Pipeline có thể được thực hiện theo cách:

Batch Processing: Xử lý dữ liệu theo lô (batch), thường áp dụng cho dữ liệu không yêu cầu cập nhật liên tục, chẳng hạn như các báo cáo hàng ngày.

Streaming Processing: Xử lý dữ liệu theo thời gian thực (real-time), giúp dữ liệu luôn được cập nhật tức thì, phù hợp cho các hệ thống theo dõi và phân tích trực tuyến.

2. Các Thành Phần Chính Của Data Pipeline

Một Data Pipeline bao gồm ba thành phần chính:

Extract (Trích xuất): Thu thập dữ liệu từ nhiều nguồn khác nhau, có thể là cơ sở dữ liệu, dịch vụ web, file logs, hoặc ứng dụng.

Transform (Chuyển đổi): Là quá trình làm sạch, chuẩn hóa và biến đổi dữ liệu để phù hợp với yêu cầu của hệ thống đích.

Load (Tải): Tải dữ liệu đã được chuyển đổi vào kho dữ liệu, cơ sở dữ liệu, hoặc một hệ thống phân tích.

3. Quy Trình Xây Dựng Data Pipeline

Dưới đây là các bước cơ bản để xây dựng một Data Pipeline hiệu quả:

Bước 1: Xác Định Mục Tiêu Và Yêu Cầu Dữ Liệu

Trước khi bắt đầu, hãy xác định rõ mục tiêu của Data Pipeline và dữ liệu bạn cần xử lý. Một số câu hỏi cần xem xét:

Nguồn dữ liệu: Bạn sẽ lấy dữ liệu từ đâu? Dữ liệu này có thể đến từ hệ thống CRM, các trang web, thiết bị IoT, hoặc các ứng dụng.

Yêu cầu về độ chính xác và tốc độ: Bạn cần xử lý dữ liệu theo thời gian thực hay chỉ cần cập nhật theo lô định kỳ?

Hệ thống lưu trữ cuối: Dữ liệu sẽ được lưu trữ ở đâu và ai sẽ là người sử dụng dữ liệu này?

Bước 2: Thiết Kế Pipeline

Khi đã hiểu rõ yêu cầu, bạn cần thiết kế cấu trúc của Data Pipeline. Các yếu tố cần thiết kế bao gồm:

Luồng dữ liệu: Xác định các bước mà dữ liệu sẽ đi qua trong pipeline, từ khi trích xuất đến khi tải.

Tần suất xử lý: Đặt lịch trình xử lý dữ liệu phù hợp với yêu cầu của doanh nghiệp, có thể là theo lô (batch) hoặc thời gian thực (streaming).

Kiểm tra và giám sát: Thiết lập các kiểm tra tự động để đảm bảo dữ liệu luôn được làm sạch và hợp lệ.

Bước 3: Chọn Công Cụ Phù Hợp

Việc lựa chọn công cụ phù hợp rất quan trọng, vì nó quyết định hiệu quả của Data Pipeline. Dưới đây là một số công cụ phổ biến:

Apache Kafka: Dùng để thu thập và truyền tải dữ liệu thời gian thực.

Apache Airflow: Quản lý và tự động hóa workflow trong pipeline.

Apache Spark: Xử lý và chuyển đổi dữ liệu ở quy mô lớn.

AWS Glue: Dịch vụ ETL không cần máy chủ, giúp tự động hóa quy trình ETL trên AWS.

dbt: Giúp chuyển đổi và làm sạch dữ liệu trong Data Warehouse.

Bước 4: Triển Khai Và Kiểm Tra

Sau khi thiết kế và chọn công cụ, triển khai pipeline của bạn và kiểm tra từng bước để đảm bảo dữ liệu được xử lý đúng cách:

Kiểm tra dữ liệu: Kiểm tra tính toàn vẹn và chính xác của dữ liệu trong từng bước. Đảm bảo rằng không có dữ liệu bị mất hoặc không chính xác trong quá trình chuyển đổi.

Theo dõi hiệu suất: Giám sát thời gian thực để kiểm tra xem pipeline có đáp ứng yêu cầu về hiệu suất không, đặc biệt với dữ liệu thời gian thực.

Bước 5: Bảo Trì Và Tối Ưu Hóa

Data Pipeline là một hệ thống liên tục thay đổi và phát triển. Sau khi triển khai, bạn cần theo dõi, bảo trì, và tối ưu hóa để đảm bảo hiệu suất luôn ổn định. Một số biện pháp bảo trì bao gồm:

Theo dõi pipeline: Sử dụng các công cụ giám sát như Grafana và Prometheus để theo dõi các chỉ số về thời gian xử lý, độ trễ và lỗi.

Tối ưu hóa quy trình ETL: Tìm cách giảm thiểu thời gian xử lý ở từng bước ETL.

Cập nhật công cụ và công nghệ: Thường xuyên cập nhật các công cụ trong pipeline để tận dụng các tính năng mới và cải thiện hiệu suất.

4. Các Công Cụ Hỗ Trợ Xây Dựng Data Pipeline

Dưới đây là một số công cụ nổi bật giúp bạn triển khai Data Pipeline một cách hiệu quả:

Apache Kafka: Công cụ mạnh mẽ cho việc thu thập và truyền tải dữ liệu streaming, cho phép xử lý và phân tích dữ liệu thời gian thực.

Apache Airflow: Cung cấp một framework mạnh mẽ để lập lịch, quản lý và tự động hóa các task trong pipeline.

Apache NiFi: Công cụ mã nguồn mở dành cho việc tự động hóa luồng dữ liệu giữa các hệ thống, với giao diện dễ sử dụng và khả năng tích hợp cao.

AWS Glue: Dịch vụ ETL của Amazon giúp dễ dàng trích xuất, chuyển đổi và tải dữ liệu lên kho dữ liệu hoặc hệ thống lưu trữ đám mây của AWS.

Google Dataflow: Công cụ mạnh mẽ để xử lý dữ liệu batch và streaming trên nền tảng đám mây của Google.

5. Các Thực Tiễn Tốt Nhất Khi Xây Dựng Data Pipeline

Dưới đây là một số thực tiễn tốt nhất để đảm bảo Data Pipeline hoạt động hiệu quả và ổn định:

Thiết lập giám sát và cảnh báo: Đảm bảo rằng bạn có hệ thống giám sát và cảnh báo khi có lỗi xảy ra trong pipeline.

Đảm bảo tính toàn vẹn của dữ liệu: Kiểm tra dữ liệu ở mỗi giai đoạn để đảm bảo không bị mất mát hoặc lỗi.

Tối ưu hóa hiệu suất: Giảm thiểu thời gian xử lý bằng cách tối ưu hóa các bước chuyển đổi dữ liệu.

Tài liệu hóa pipeline: Ghi chép lại các bước và luồng xử lý để dễ dàng quản lý và bảo trì sau này.

Bảo mật dữ liệu: Đảm bảo rằng dữ liệu luôn được mã hóa và bảo vệ trong quá trình truyền tải.

Kết Luận

Xây dựng Data Pipeline là một bước quan trọng để doanh nghiệp có thể xử lý và khai thác dữ liệu hiệu quả. Bằng cách áp dụng quy trình và công cụ phù hợp, bạn có thể xây dựng các pipeline dữ liệu tự động, đáng tin cậy, và dễ bảo trì. Việc làm chủ Data Pipeline không chỉ giúp Data Engineer tăng hiệu suất làm việc mà còn tạo ra giá trị lớn cho doanh nghiệp thông qua việc tận dụng dữ liệu một cách tối ưu.

Hướng Dẫn Xây Dựng Pipeline Dữ Liệu Hiệu Quả

DATALIZE

Address: No. 17, Hoa Binh 2 Lane, Minh Khai Street, Hai Ba Trung District, Hanoi

Hotline: 037 8239 666

Email: Hi@datalize.cloud

Website: https://datalize.cloud/

CONTACT

CONTACT WITH US